近年来,由于对越来越小型化和越来越低的功耗以支持电池供电的电子设备的需求不断增长,低功耗芯片的设计发挥了重要作用。采用人工智能(AI) -越来越多地出现在可穿戴设备,物联网设备,以及更普遍,在嵌入式系统-被强加致力于与更密集,更创新的架构和制造工艺开发低功耗芯片设计艰巨挑战.

需要适当的功耗分析技术和工具来帮助工程师设计高级 AI 芯片,以满足他们的特定要求,例如整体功能、可制造性、成本和可靠性。

低功耗设计

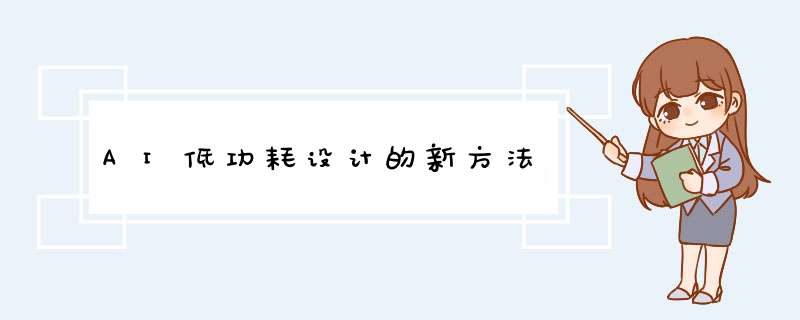

低功耗设计的目标是降低集成电路 (IC) 的整体动态和静态功耗,这是实现下一代应用的关键方面。该过程涉及动态和静态功率的降低。动态功率包括开关和短路功率分析,而静态功率主要包括漏电流分析。包含上述三个贡献的功率方程如图 1 所示。

图 1:电源组件和方程式(来源:Synopsys)

在 IC 制造工艺基于 90 nm 至 16 nm 技术的年代,设计人员的注意力集中在降低泄漏功率上,因为它比动态功率(10%)具有更大的权重(85% 至 95%)到 15%)。随着随后从 16 nm 过渡到 14 nm,功率方程发生了变化;泄漏功率得到了很好的控制,而动态功率则成为一个更重要的问题。这首先是由于从平面到 FinFET 晶体管架构的转变,多栅极器件构建在衬底上,其中栅极放置在通道的两侧、三侧或四侧或环绕通道,形成一个双门甚至多门 3D 结构。

未来几年,随着电子制造领域的不断进步,7nm、5nm甚至3nm的制造工艺将再次凸显泄漏功率的重要性。

人工智能的新挑战

人工智能在电子应用中的日益广泛使用带来了新型的电源挑战。性能、功耗和面积 (PPA) 范例仍然是设计人员要实现的目标。不同的是,随着人工智能芯片的引入,在不牺牲功率的情况下最大化功率变得更加困难。今天,性能实际上受到功率的限制,并且很难在不担心分散的热量和热管理的情况下向芯片的每个部分可靠地供电。

矢量的质量(定义为 SoC 在真实系统中工作时所看到的真实活动)对于动态功耗分析和优化至关重要。

“最大的问题是估计工作负载,尤其是当 SoC 在现场运行时,在真实系统上,”新思科技设计集团的低功耗架构师兼研究员 Godwin Maben 说。“我们需要了解测量和优化动态功率的工作量。谈到人工智能,没有预定义的基准。我们需要识别这些工作负载,确保捕获它们并尽早调试电源。”

低功耗设计意味着了解功耗对软件开发、硬件设计和制造的影响。它不是一个单一的步骤,应该贯穿整个芯片设计过程,目的是降低整体动态和静态功耗。

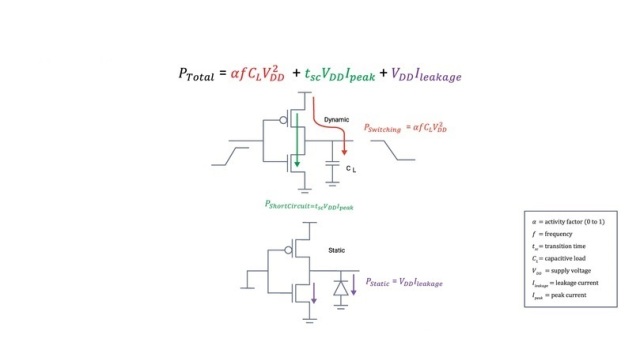

如图 2 所示,设计和验证方法分为五个主要阶段:

静态功耗验证与探索

动态功率验证和分析

软件驱动的电源分析

电源实现

登出

图 2:设计和验证阶段(来源:Synopsys)

仿真的作用

提供有关 SoC 功耗的估计是一项艰巨的任务,这要求设计人员设置能够尽可能忠实地再现真实工作条件的测试平台。能够满足这些要求的最佳系统是仿真。

对 AI 芯片进行功耗分析需要合适的工具,能够获取和处理数百 GB 的数据,包括数万亿或数十亿个时钟周期。仿真系统内的功率分析有助于解决这个问题,因为它只能识别功率分析感兴趣的窗口。

“人工智能芯片带来了两个新概念,”马本说。“第一个是验证调试具有挑战性,因为它需要很长时间。第二个是如何开发应用软件,可以在芯片启动时准备好。这就是仿真和原型设计的概念出现的地方。”

由于其独特的快速仿真架构、最先进的商用 FPGA 以及基于 FPGA 的仿真软件的创新,Synopsys 的 ZeBu 服务器是业界最快的仿真系统, 其性能 是传统仿真解决方案的2 倍。ZeBu 软件为用户提供了有价值的工具,例如快速编译器、高级调试(包括与 Verdi 的本地集成)、仿真加速、混合仿真和功耗分析。

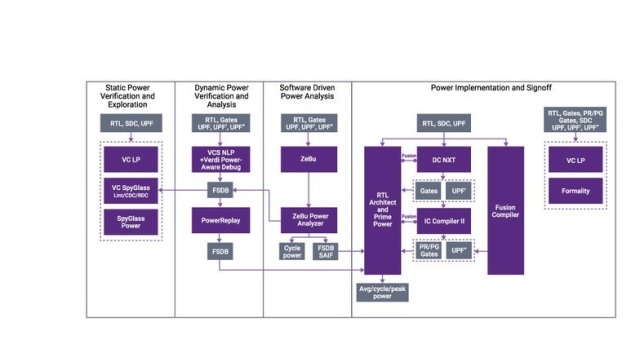

当应用程序在模拟器上运行时,它最终会被转换为 SoC 的向量。然后可以使用这些向量来运行仿真,从而验证仿真器中芯片的功能。仿真是获得工作负载的合适平台,因为它生成针对功耗分析优化的向量。如图 3 所示,PrimePower RTL 使用 ZeBu EmPower 矢量为设计人员提供有用的信息。

图 3:概要软件驱动的 SoC 活动(来源:Synopsys)

AI 芯片使用大量数学函数,主要是乘法和矩阵运算,由专用和优化的组合逻辑执行。

“当我们进入这些计算密集型应用程序时,设计师担心的新概念是较低几何结构的故障功率,”Maben 说。“故障功率占总功率的 25% 以上,我们知道故障功率意味着浪费功率。”

毛刺的数量与 SoC 执行的 *** 作数量成正比,这使得毛刺成为 AI 加速需要解决的重要问题。故障有两种类型:惯性故障和运输故障。惯性毛刺可以在架构上解决,而传输毛刺是由于通过逻辑单元的延迟,导致逻辑门输入处的不同到达时间。毛刺正在成为一个非常大的话题,因为它们很难优化,也很难衡量。

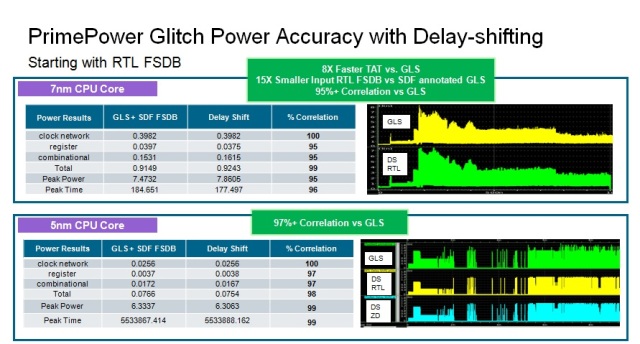

Synopsys 提供端到端 RTL 到门故障电源分析和优化解决方案。在 RTL,PrimePower RTL(参见图 4)可以计算和报告每个层次结构的故障,它还可以指向生成最高级别故障的 RTL 源代码行。所述 的PrimePower溶液 还提供对延迟/毛刺感知使用RTL仿真,并且可以执行使用零延迟门级仿真或定时感知仿真密切相关,以SPICE功率数毛刺功率分析矢量生成。

“毛刺正在成为主导,尤其是在 AI 芯片和更低的几何形状中,”Maben 说。“有像 PrimePower RTL 这样的工具,它可以告诉设计人员哪些块更容易出现故障并对其进行排名。然后,建筑师可以更改架构以减少故障。”

图 4:PrimePower RTL 毛刺功率分析(来源:Synopsys)

审核编辑:汤梓红

欢迎分享,转载请注明来源:内存溢出

微信扫一扫

微信扫一扫

支付宝扫一扫

支付宝扫一扫

评论列表(0条)