随着数字融合的进一步发展,系统的设计和实现需要更大的灵活性,以解决将完全不同的标准和要求整合为同类产品时引发的诸多问题。本文介绍FPGA在视频处理中的应用,与ASSP和芯片组解决方案相比,FPGA可根据目前设计工程师的实际需求提供不同层次的灵活性,并保持明显优于传统DSP的性能。

实时视频处理对系统性能的要求极高,因此几乎所有只具最简单功能的通用DSP都不具备这项功能。可程序逻辑组件允许设计人员利用平行处理技术实现视频信号处理算法,并且只需单个组件就能实现期望的性能。基于DSP的解决方案通常需要在单板上嵌入许多DSP,以得到必需的处理能力,这无疑将增加程序资源开销和数据内存资源开销。

藉由在实时环境下进行视频处理,系统工程人员可将帧内存需求和数据缓冲需求降至最低,而在非实时应用中则无需如此。

随着业界积极推动高质量视频开发以及压缩格式的不断改进,系统处理速度也不断提高。可程序逻辑组件也采用了专用寻呼设备中广泛采用的FPGA组件架构。由于FPGA制程的发展遵循摩尔定律,因此与稍早开发的同种产品相比,新产品能以更具吸引力的成本优势实现相同的功能和性能。

这种趋势的一大源动力来自网络、广播、处理和显示技术的融合,即业界所称的‘数位融合’。由于在极窄的传输信道(如无线信道)上发送高频宽视频数据并保持适当的业务质量(QoS)极其困难,因此设计人员展开了广泛的研究,致力于改进纠错、压缩和图像处理技术,这些研究均建立在FPGA实现的基础上。

图像压缩/解压缩-DCT/IDCT

目前在数字视频系统中主要使用的视频压缩格式是MPEG2,已广泛应用于数字电视、视讯转换盒、数字卫星系统、高清晰度电视(HDTV)译码器、DVD播放器、视频会议设备和网络电话中。原始的数字视频信息总需要进行压缩,以便藉由适当的传输通道传送或者储存在适当的介质(如磁盘)中。此外还有许多新标准即将或正在推出,包括最为引人注目的MPEG4,但大多数基于该技术的产品仍在开发中。

MPEG2和MPEG4算法的核心是一种称为离散余弦变换(DCT)的作业。DCT的基本原理是取图素块的平方并除去观察者察觉不到的冗余信息。为了解压缩数据,还需要反离散余弦(IDCT)运算。

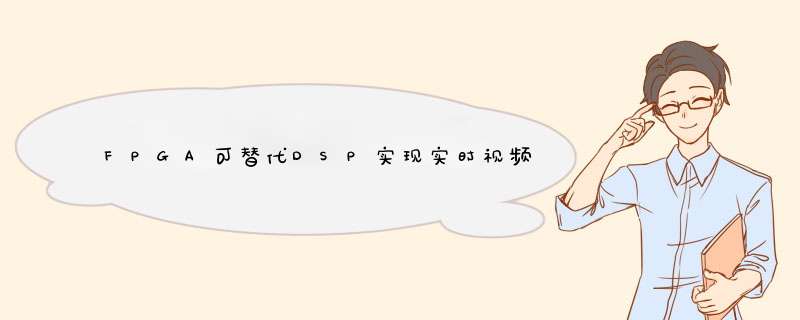

虽然MPEG算法中的DCT部份已经标准化并能在FPGA中有效实现,MPEG编码仍有许多部份尚未明确规定。而正是这些不明确部份使得一家公司的产品得以区别于竞争对手,并开发出拥有自主产权的算法。许多专用MPEG译码器在这些部份(如运动估计模块)使用了FPGA。因为FPGA可重新配置,因此组件能方便地进行刷新,并在整个开发阶段(包括配置之后)整合新算法,而完全依赖标准ASSP解决方案的公司由于受到自身能力的限制而无法开发出类似产品,因此市场风险较大(图1)。

色彩空间转换

视频系统另一重要部份是色彩空间转换,该制程规定了图像的表示方法,例如由一种色彩格式转化为另一种不同的色彩格式。

人眼传感器只能检测到波长介于400nm至700nm之间的可见光,这些传感器称为圆锥细胞,具有三种不同的类型:红光圆锥细胞、绿光圆锥细胞和蓝光圆锥细胞。如果单波长的光可见,这三种传感器的相对反应能使我们鉴别出光的颜色。该现象极具实用价值,因为这意味着我们只需简单地按不同比例将上述三种光混合,就能产生各种颜色的光。这就是著名的三色原理,它在彩电系统中获得了广泛的应用。

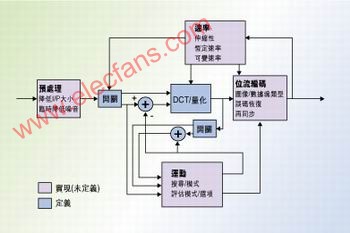

我们可以在3维立方体中藉由绘制三原色(即红色、绿色和蓝色,简写为RGB)的构成比率图以表示各种颜色,其中黑色位于原点,而白色则位于原点的斜对角。得到的立方体就是著名的RGB色彩空间。

不管最终的显示媒体是纸张、LED、CRT或等离子显示器,图像总可细分为很多个图素(例如HDTV可具备1920×1080个图素)。同时每种媒体之间又存在些许差异,但其基本原理都是每个图素由一定比例的红色、绿色或蓝色构成,构成的比例取决于驱动显示的电压信号。

利用RGB格式处理图像时,每个图素由3个分别对应于三原色的8位或10位字确定,因而这不是一种最高效的处理方法。这种格式下,必须在所有的红色、绿色和蓝色信道上对图素进行作业,所需的储存空间和数据频宽毫无疑问将比其它可供选择的色彩格式更大。为了解决这个问题,许多广播标准(如欧洲的PAL和北美的NTSC电视系统)均采用亮度和色度视频信号。因此,不同的色彩格式之间需要一种能互相转换的机制,即色彩空间转换(图2)。

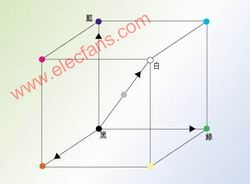

用硬件实现这些电路则相对比较简单,只需要知道从一种格式映像到另一种格式的系数。最通用的一种转换是由RGB格式转换至YCbCr格式(反之则从YCbCr格式转换至RGB格式)。研究显示,人眼察觉到的光亮度信息(Y)的60%至70%来自绿色光。红色和蓝色信道实际上只是亮度信息的复制,因此这些重复信息完全可以去除掉。最终的结果是图像可用表征色度和亮度的信号来表示。在这种格式下,8位系统规定亮度的取值范围介于16至235之间,而Cb和Cr信号的取值范围介于16至240之间,并规定128表示亮度为0。

可用如下的方程将YCbCr空间中的色彩转换为RGB色彩空间中的色彩:

R'=1.164*(Y-16)+1.596*(Cr-128)

G'=1.164*(Y-16)-0.813*(Cr-128)-0.392*(Cb-128)

B'=1.164*(Y-16)+1.596*(Cr-128)

R'G'B'表示图像灰度校正RGB值。例如,CRT显示器的信号振幅与输出密度之间存在非线性,如果在显示信号之前进行图像灰度校正,就能使信号振幅与输出密度间的关系趋于线性。输出增益同样必须限定低于特定的临界值,以减少图像暗区中的传输噪音(图3)。

我们可以采用许多可行的方法实现所需的乘积功能,如利用内存、逻辑组件或嵌入式乘法器[1][2]。

显然,HDTV系统所需的74.25MHz数据率可轻松地达到,而且还可以尝试不同的设计折衷考虑,如系统精确度和设计范围之间的折衷。例如,为了保证3%的转换误差,YCbCr至RGB色彩空间转换器的设计尺寸可以至少减小一半。这或许超出了大多数显示器产品所能承受的范围,但仍然能被其它的应用系统接受,如机器视觉或安全系统。采用FPGA的系统架构就能调整应用系统的算法,由此实现最佳的性能和效率。

实时图像和视频处理功能

标准DSP自身性能上的缺陷促进了专门解决此难题的专用设计芯片(如媒体处理器)的发展。但是,这些组件极低的灵活度往往使其局限于非常有限的应用中并容易产生性能瓶颈。在高分辨率系统(如HDTV和医疗成像系统)中,基于处理器的方法受到的限制尤为明显。从根本上讲,处理器的分辨率受限于分配给滤波器每个抽头或每个转换阶段时钟周期的数目。一旦达到极限条件,通常除了增加额外的DSP部件外别无选择。FPGA可以藉由定制调整提供最具实用价值的高性能高效率产品。设计人员可在适用范围和速率之间进行折衷考虑,从而以比DSP时钟低得多的速率实现指定功能。

例如Visicom公司发现,在中值滤波器应用中[3],DSP处理器需要67个时钟周期执行算法,而FPGA只需工作在25MHz频率下,因为FPGA能平行实现该功能。实现上述功能的DSP必须工作在1.5GHz频率下,可见在此特定应用中,FPGA解决方案的处理能力可以达到100MHz DSP处理器的17倍。

许多实时图像和视频处理功能均适合于用FPGA组件来实现,包括:图像旋转、图像缩放色彩校正和色度校正、阴影增强、边缘检测、直方图功能、锐化、中值滤波器和斑点分析等。

许多功能都针对特定的应用和系统,并构建在核心架构(如2D-FIR滤波器)之上。我们可以利用HDL设计语言或高级内核设计工具(如Xilinx CoreGen软件)中的DSP程序块迅速实现这些功能。此外,还能藉由系统级设计方法,利用Matlabs Simulink和Xilinx SystemGenerator工具进一步减少设计和模拟时间。

欢迎分享,转载请注明来源:内存溢出

微信扫一扫

微信扫一扫

支付宝扫一扫

支付宝扫一扫

评论列表(0条)