WD的SN840 NVMeSSD新品并没有太吸引我注意,因为它还是PCIe 3.0接口的,要知道Intel的PCIe 4.0 SSD都已经推出了。(我在《看不懂的性能和寿命?Intel Optane持久内存200、LGA4189杂谈》中提到过)

但上面这个NVMe-oF(NVMe over Fabric)EBOF(区别于普通JBOF的第一个字母表示Ethernet)我就有点兴趣了。前一段看到刘爱贵博士的公司——大道云行宣布的分布式软件定义存储新品,使用了一家国内的E-JBOF,想从官网找公开资料学习下都不太多。在这点上国际品牌往往要做得完善一些,否则我也写不出本文的分享。

从SAS JBOD到NVMe JBOF和EBOF

谈到NVMe JBOF的前身,SAS JBOD磁盘(HDD/SSD)扩展柜不得不提,下面只用一张图简单交代下JBOD里的SAS Expander控制模块。

上图从10年前的一段视频里截出,可以说是LSI在6Gb/s SAS时代的经典之一(Dell PowerVault MD1200/1220 JBOD基本相同),也勾起了我一段曾经美好的回忆。2U驱动器机箱里有2个HA路径的SAS Expander——只用LSI SAS2X36芯片作为核心即可。

相比之下,NVMe-oFJBOF/EBOF至少要在物理上把PCIe转换为以太网,所以结构不可能如此简单。我们先来看看下面这块“网卡”。

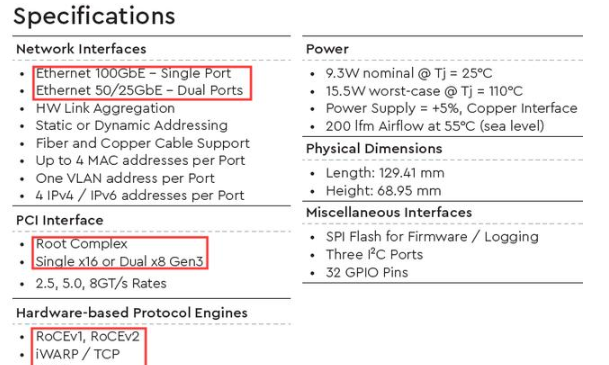

这颗芯片的型号是WDRapidFlex A1000 NVMe-oF ASIC,对应的板卡为RapidFlex C1000 NVMe-oF Adapter,不难看出是用来干啥的。规格如下:

其网口部分提供1个100GbE或者2个50/25GbE以太网,协议支持RoCE、iWARP/TCP,看产品名称自然也支持NVMe。PCIe接口支持Root Complex,看来是用于连接NVMe SSD的;PCIe Gen3 x16还能拆分成2个x8来使用(连接多个PCIeSwitch)。

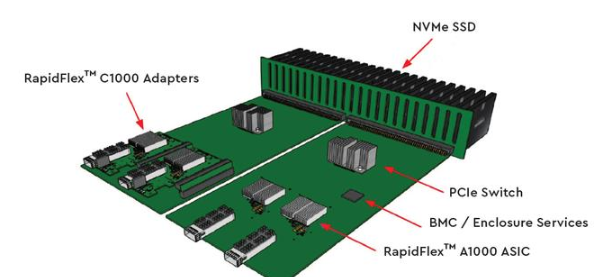

上图是基于RapidFlex A1000的EBOF参考架构。位于机箱前部的NVMe SSD通过热插拔背板连接到2块控制电路板——应该支持双端口SSD的2个PCIe 3.0 x2多路径访问,然后经过PCIe Switch之后,就连接到几个RapidFlex A1000 ASIC对前端服务器提供NVMe-oF访问。同时有BMC / 机箱服务模块用于带外管理。

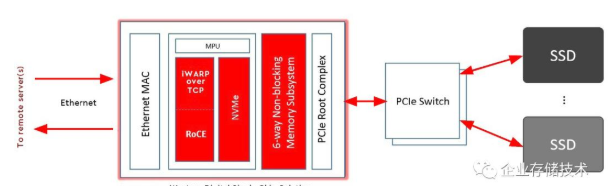

看这个WD单芯片解决方案就更清楚了。所谓“6-way无阻塞内存子系统”,其实RapidFlex A1000 ASIC是无需DRAM内存工作的,它的工作其实很单一——就是那个“MPU”实现NVMe(连接SSD)到NVMe-oF(over RDMA)之间的转换。

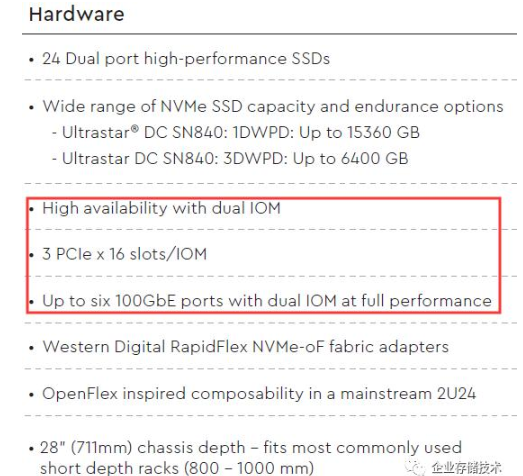

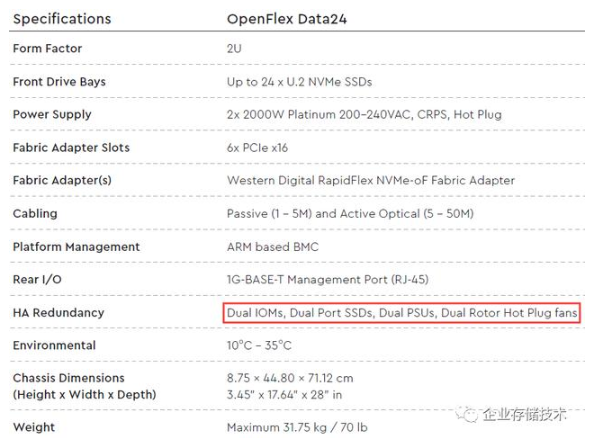

再来看看WD OpenFlex Data24 NVMe JBOF(EBOF)的后视图。左右2个IOM模块上各自可以插3块网卡,应该就是前面提到的RapidFlex C1000 NVMe-oF Adapter。

这里重点看一下OpenFlex Data24的高可用和性能设计。在2个IOM模块中,每个上面应该是用了不低于96 lane PCIe 3.0 Switch芯片——下行48 lane连接NVMe SSD,然后3个x16连接RapidFlex网卡。除了到以太网那里带宽打一点折扣之外,PCIe链路的“收敛比”是1:1性能无损的。

OpenFlex Data24给出的性能指标是13.2M IOPS和70.7GB/s,平均每块SSD接近55万IOPS和3GB/s带宽,这个几乎把6个100GbE网口跑满了,每块网卡平均220万IOPS。

NVMe-oF EBOF高级实现方式、闪存阵列的区别

前面讨论的WD产品只是最基本的以太网JBOF,可以说与SAS JBOD和PCIeNVMe JBOF的地位没有本质区别——支持用来连接盘,而并没有更多高级管理功能。再往上一点的方案是什么呢?下面我拿Mellanox和Broadcom的产品来简单举个例。

关于MellanoxBlueField我有2篇写的比较早,收录在《存储网络交换、NVMe oF》专辑中,大家也可以找最新的资料看看。

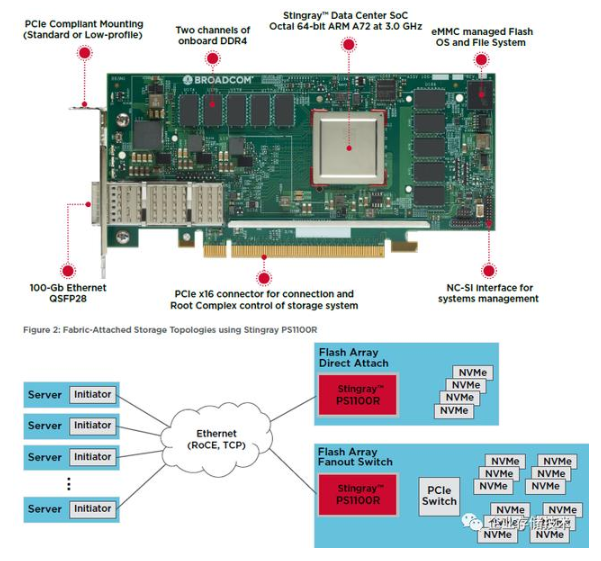

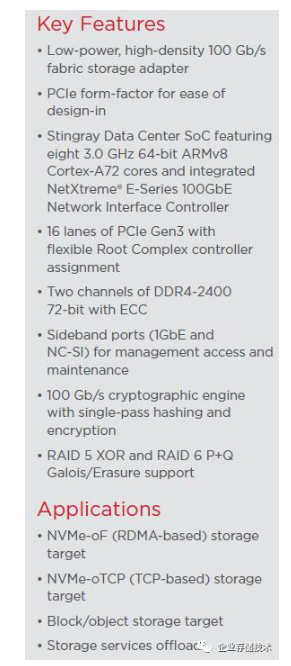

上图这款卡,在WinnieShao博士的大作《智能网卡SmartNIC:“大”x86 Server中的“小”armServer》中也被提到过。BroadcomSTIngray板卡的主控芯片BCM58800也是一颗ARM SoC,它在拓扑图中的位置有点类似于前面的WD RapidFlex,但既然敢称为闪存阵列(Flash Array)而不只是E-JBOF自然有所不同。

上图这份资料有点老。ARM和网卡部分我就不多谈了,Broadcom本身就是做网络出身的。SoC同时包含双通道DDR4内存控制器,具备接近100Gb/s Hash和加密引擎(也能用于重删)、RAID 5 XOR和RAID 6 P+Q Galois/Erasure纠删码支持。

除了基于RDMA的NVMe-oF之外,STIngraySmartNIC的应用方案还包括NVMe-TCP(扩展阅读:《NVMe over TCP:iSCSI的接班人?》),这一点我理解WD RapidFlex网卡就做不到了。类似的还有对象存储,已经超出了JBOF/EBOF的基本功能范畴。

关于存储服务offload卸载这一块,如果是传统企业存储市场中功能强大的闪存阵列,只靠SmartNIC显然又不够了。下图引用自《DellEMC PowerStore详解:NVMe+SAS全闪存阵列,还是一体机?》,只是举个例。

关于写缓存镜像,以及数据缩减(压缩/重删)处理,只是PowerStore存储系统数据路径中的一部分流程而已。其实我理解NVRAM盘只是为了保障数据的持久化(估计是一个副本),真正的处理还是要放在DRAM主内存中才能高效。至于更多的高级存储服务,就需要用到控制器中强大的服务器级别CPU了(具体到PowerStore使用的是XeonScalable)。

欢迎分享,转载请注明来源:内存溢出

微信扫一扫

微信扫一扫

支付宝扫一扫

支付宝扫一扫

评论列表(0条)