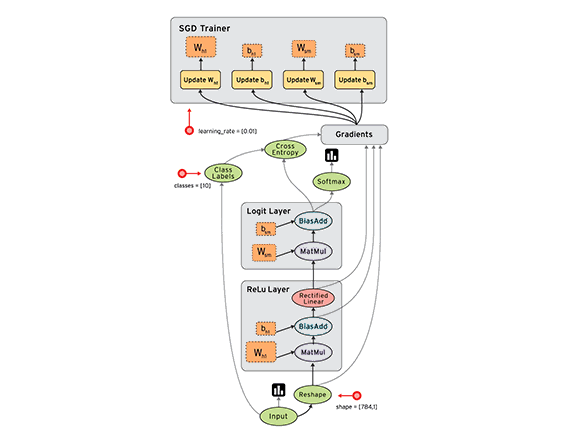

其实早在去年年底,Google就已开源深度学习系统TensorFlow。

关于深度学习开源软件

简单回顾下TensorFlow——一个开源软件库使用数据流图进行数值计算。图中的节点代表数学运算,而图形边缘表示多维数据数组(张量)之间的沟通,灵活的架构允许你计算部署到一个或多个CPU或GPU,虽然一开始谷歌大脑开发团队是主要进行机器学习的目的,和深层神经网络的研究,但总体系统足以适用于各种各样的其他领域。

这就已经使得第一代系统DistBelief大幅度被简化。因为在深度学习算法CNN流行之前,机器学习的特征学习主要是通过人类根据自身拥有的领域知识或经验来提取合适的特征,而特征的好坏直接决定了机器学习运用的成败。

但是对于图像或者语音而言,人类提取特征的标准也较难形容,譬如我们识别一朵红玫瑰,我们会觉得红玫瑰有刺、有颜色、有叶子、有花瓣和茎,而且这几个部件之间有一定组织关联以及空间约束,譬如刺在茎上的分布有一定的距离、花瓣在开放之后与尚未开放之前有一定的紧密度差距等,但是我们该用怎样的语言来描述人类“眼睛”呢?如果认真想一想就会发现挺难的。

但是人类本质上是小样本监督学习,或者无监督学习,现有的深度学习还无法做到这一点,这也是深度学习领域的研究着重需要突破的点。因为我们只要给几张开放程度不同的红玫瑰的照片给人看,他就可以学习到都些是什么样的红玫瑰。人似乎可以自动“学习”出特征,或者说你给了他看几张红玫瑰的照片,然后问红玫瑰有什么特征,他也会就可以隐约告诉你红玫瑰有什么特征,甚至是不同开放程度特有的特征,这些特征是百合花、水仙花或者其他的花没有的。

而深度学习就是人工神经网络ANN (ArTIficial Neural Network),是在借鉴一些人脑运行的机制基础上模拟神经元的连接设计的。因为深度学习算法相较于传统的机器学习在一些重要的任务上取得了大幅度的提升,以至于引发一场热潮甚至形容为革命也不为过,但是深度学习需要海量已标记的数据进行长时间的训练,其对计算能力的要求非常高。深度学习是计算密集型的算法,在近几年,随着计算能力的增强,深度神经网络对比许多传统机器学习数据集优势体现出来之后,逐渐用到图像、语言,它不再需要人工提取特征,自动学出特征后效果提升更明显。

最初使用传统的CPU(中央处理器,Central Processing Unit)计算时,为了保证算法的实时性,会需要使用大量的CPU来进行并行计算,就像Google Brain项目用了16000个CPU Core的并行计算平台训练来保证算法的运行速度。

深度学习是计算密集型的算法,所以在GPU (图形处理器,Graphic Processing Unit)、FPGA(现场可编程门阵列,Field-Programmable Gate Array)和TPU等超速处理硬件发展起来后,CPU 在机器学习上进行的计算量大大减少,但是CPU并不会完全被取代,因为CPU较为灵活,且擅长于单一而有深度的运算,还可以做其他事情。

比如当使用GPU做深度学习计算时,CPU还是需要在代码中写入并读取变量、执行指令、启动在GPU上的函数调用、创建小批量的数据等,但是不再需要取指、译码等,所以Google在I/O大会上也强调了其并没完全抛弃CPU,TPU 只是在一些辅助使用在特定的应用中。

TPU对谷歌意味着什么?

谷歌专门开发的应用于深度神经网络的软件引擎。谷歌表示,按照摩尔定律的增长速度,现在的TPU的计算能力相当于未来七年才能达到的计算水平,每瓦能为机器学习提供更高的量级指令,这意味它可以用更少的晶体进行每一个 *** 作,也就是在一秒内进行更多的 *** 作。并且谷歌将其与Deep learning系统平台TensorFlow进行了深度绑定,可以获得更好的支持,做更强的生态,包括搜索、无人驾驶汽车、智能语音等100多个需要使用机器学习技术的项目。

欢迎分享,转载请注明来源:内存溢出

微信扫一扫

微信扫一扫

支付宝扫一扫

支付宝扫一扫

评论列表(0条)