作者:李卫忠 文章来源:doit

超大规模云计算中心、电子商务和社交网络数据中心,正面临着数据类型复杂的工作负载加速之难题。

数据中心加速的主要途径

传统CPU处理能力的需要突破已经成为共识,目前的途径主要有以下几类:

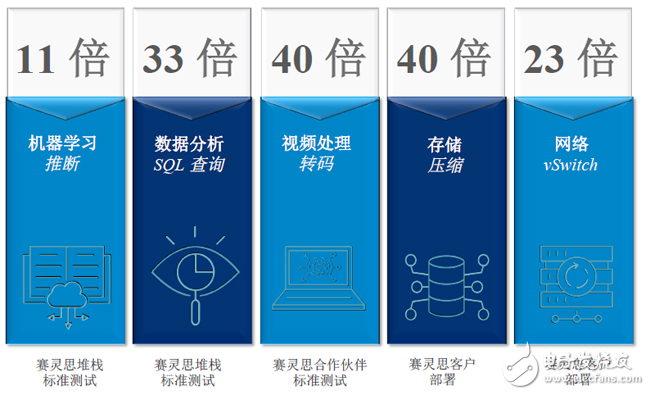

途径一,ASIC:经历了几十年的发展演变,为专门目的而设计的ASIC,由于面向特定用户的需求,在加速效率上可圈可点。但是,设计周期长、成本贵、应用范围窄的通病,使ASIC仅适合于批量很大或者对产品成本不计较的场合。

途径二,GPU:随着近年来机器学习等领域的突飞猛进,GPU也早已经不再局限于3D图形处理,其在浮点运算、并行计算等部分计算方面的特性已经引起业界越来越多的关注,尤其是目前最大的独立芯片生产销售商NVIDIA有些如日中天的感觉,但其在应用广度上的通用性仍然有待时间的检验。

途径三,FPGA:它作为半定制的ASIC而出现,既解决了定制电路的不足,又在性能与应用广度上显示出优势,英特尔已经积极布局,推出CPU+FPGA架构,赛灵思池化FPGA近期取得的一些新成果,也使FPGA进入数据中心加速的主角地位。

赛灵思数据中心加速取得重大进展

日前,赛灵思在2016全球超算大会(SC 16)上宣布推出一套全新的技术——赛灵思可重配置加速堆栈方案,旨在帮助全球最大的云服务供应商快速开发和部署加速平台。通过赛灵思FPGA,该方案比x86服务器CPU提高40倍;比竞争型FPGA方案提高了6倍。

赛灵思全球战略高级副总裁Steve Glaser和云战略总监Andy walsh对赛灵思最新的FPGA动态可重配置堆栈技术进行了详细的介绍。

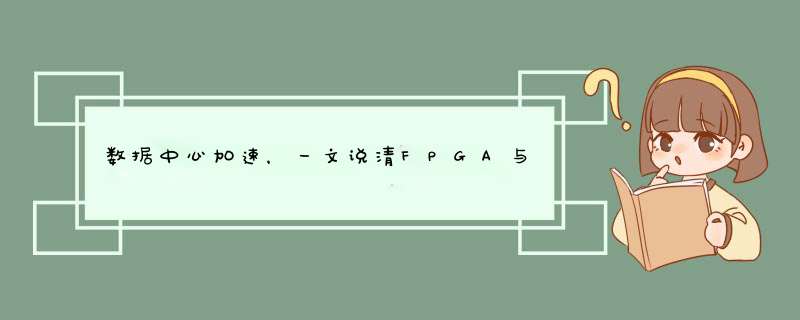

超大规模工作负载中,赛灵思FPGA的单位功耗性能与CPU对比

与服务器CPU的性能对比,单位功耗性能在机器学习推断方面提高了11倍;数据分析SQL查询方面提升了33倍;视频处理转码提高40倍;存储压缩提高40倍;网络vSwitch可提高23倍。

在以计算效率和加速利用率所组成的象限中,赛灵思池化FPGA的单位功耗性能实现了比Altera FPGA高2-6倍,相关产品将在明年上市。

数据中心加速主要途径比较

问题一:赛灵思FPGA VS. 英特尔集成式MCM CPU+FPGA

赛灵思全球战略高级副总裁Steve Glaser认为,在代表应用广度的横轴和加速利用率的纵轴所组成的象限图中,赛灵思池化FPGA在超大规模网络应用方面已经遥遥领先;英特尔注意到FPGA的优势,但其集成式MCM CPU+FPGA目前只能解决中小企业的问题。

问题二:赛灵思FPGA VS. 英伟达GPU

面对日益火爆的GPU,Steve指出,GPU和定制ASIC在应用广度方面与FPGA相比远远不足;

以机器学习加速为例,使用神经网络分类图像、翻译文本和语音、识别无结构数据中的底层模式,需要“两阶段”法。

第一阶段(培训),使用海量加标记的样本数据和计算培训神经网络,英伟达GPU擅长的这一领域只占机器学习5%的市场规模。

一旦网络培训完成,便进入第二个阶段(推断),通过受训的神经网络处理新数据样本或查询,以确定其可能的级别。这一占机器学习加速90%的市场正是赛灵思FPGA角逐的天下。

推断是当今最大规模数据中心中的一个巨大的工作负载,因为它负责实现广泛的日益扩展的重要应用,例如语言翻译、自然语言接口、照片和视频内容识别,以及网上产品选择与促销。其中两个最大的人工智能市场分别是无人驾驶汽车和机器人。

而赛灵思池化FPGA将机器学习推断计算效率提升了2-6倍。

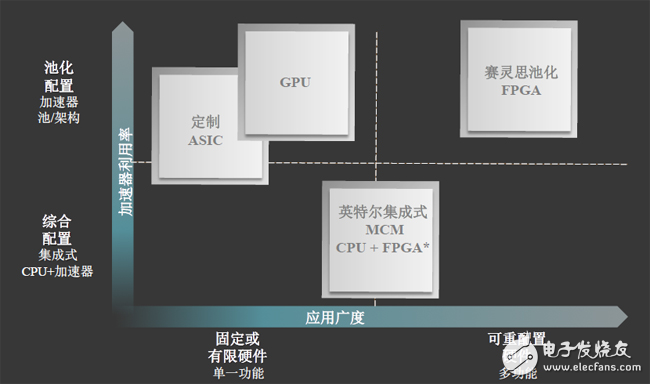

近年来赛灵思在加速领域的里程碑事件回顾

回顾一下赛灵思在云计算加速领域的重要里程碑事件:

赛灵思近年来在加速领域的里程碑事件

2014~2015年,赛灵思与高通、IBM等公司展开合作,并在业界推出首款20纳米和16纳米数据中心产品,比竞争对手提前了1年又1个季度。此外,赛灵思还积极推动制定行业标准的CCIX联盟的发展。

目前,全球七大超大规模云服务公司中,已有3家采用了赛灵思FPGA,其中:

欢迎分享,转载请注明来源:内存溢出

微信扫一扫

微信扫一扫

支付宝扫一扫

支付宝扫一扫

评论列表(0条)