本文描述了猿辅导开源分布式机器学习库ytk-learn及分布式通信库ytk-mp4j的相关内容,可实现在多应用场景中使用。ytk-learn 是基于Java的高效分布式机器学习库, 简单易用,文档详细,只需要用户安装Java 8运行时环境即可,而且所有模型都有可运行的demo。

猿辅导公司开源了两个机器学习项目——ytk-learn, ytk-mp4j,其中 ytk-mp4j 是一个高效的分布式通信库,基于该通信库我们实现了 ytk-learn 分布式机器学习库,该机器学习库目前在猿辅导很多应用场景中使用,比如,自适应学习、学生高考分预测、数据挖掘、课程推荐等。

ytk-learn分布式机器学习库 项目背景LR(LogisTIc Regression), GBDT(Gradient BoosTIng Decision Tree), FM(FactorizaTIon Machines), FFM(Field-aware FactorizaTIon Machines) 模型是广告点击率预测和推荐系统中广泛使用的模型,但是到目前为止几乎没有一个高效的机器学习开源项目集这几种常用模型于一身,而且很多机器学习开源项目只能在特定计算平台下使用,最重要的是不能高效的整合到线上生产环境中。ytk-learn 就是解决以上问题而产生的。

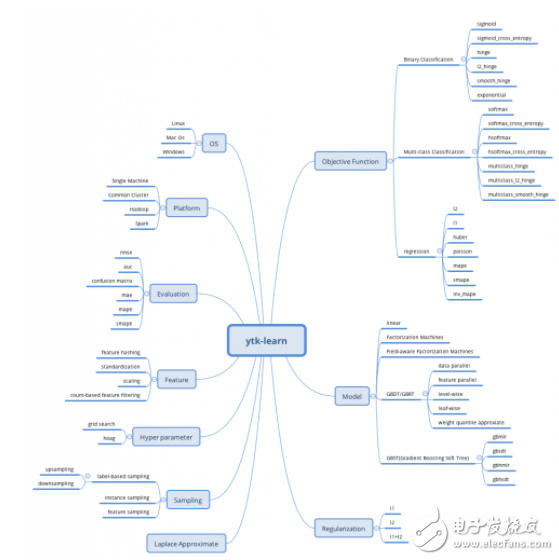

图1 ytk-learn 特性概略

项目简介ytk-learn 是基于Java的高效分布式机器学习库,实现大量的主流传统机器学习模型(GBDT, LR, FM, FFM等)和loss函数,支持单机多线程、多机集群及分布式计算环境。

其中 GBDT/GBRT 的实现借鉴吸收了 XGBoost 和 LightGBM 的大部分有用特性,支持特征并行和数据并行,支持传统的精确算法和直方图近似算法,支持 level-wise 或者 leaf-wise 的建树方式,而且还实现了分布式带权分位数近似。在单机数据并行的场景中训练速度跟 XGBoost 相当,在非$2^n$台机器的分布式场景中比 LightGBM 速度更快,更稳定。

传统的 GBDT/GBRT 在含有大量 Categorical 特征的场景中无法使用,我们实现了多种适用于大量 Categorical特征的 GBST(Gradient Boosting Soft Tree)模型,在猿辅导的点击率预测和推荐场景中效果明显好于LR、FM、FFM等模型。

ytk-learn 实现了改进的 Hoag(Hyperparameter optimization with approximate gradient, ICML2016)算法,能够自动高效的进行超参数搜索。当目标函数是凸函数时,hoag 能快速得到最优超参数(kaggle 比赛利器),效率明显高于传统的网格超参数搜索算法(grid search),而且在非凸目标函数场景中也适用。

其他特性:

1. 简单易用,文档详细,只需要用户安装Java 8运行时环境即可,而且所有模型都有可运行的demo

2. 支持主流的 *** 作系统:Linux,Windows,Mac OS,仅需安装Java8运行环境即可使用

3. 支持单机多线程,多机集群及分布式环境(Hadoop,Spark),相比Hadoop Mahout, Spark MLlib效率高很多

4. 提供简单易用的在线预测代码,可以方便整合到线上生成环境

5. 支持多种目标函数和评估指标,支持L1,L2,L1+L2正则

6. 树模型支持样本采样,特征采样,提供初始预估值的训练

7. 支持特征预处理(归一化,缩放),特征哈希,特征过滤,基于样本标签采样

8. 提供了读取数据时进行高效数据处理的python脚本

9. 训练模型支持checkpoint,继续训练

10. LR 支持 Laplace 近似,方便做 Exploitation&Exploration

11. 基于猿辅导的 ytk-mp4j 通信库,分布式训练效率非常高

欢迎分享,转载请注明来源:内存溢出

微信扫一扫

微信扫一扫

支付宝扫一扫

支付宝扫一扫

评论列表(0条)