2018年可以认为是人工智能(AI)大爆发的一年。你只需看看那些标语中带AI一词数量,宣称自己 AI 创业公司的数量,大公司提到 AI 战略的次数,以及技术顶会中爆满的 AI 专场,你就知道人工智能已经无处不在。但是,即使是这样,AI 也只是称为了一个流行语而已,但实际上 AI 的本质是什么,我相信很多人都不知道。

图 1: 这些年来大肆宣传的概念

回顾这些年宣传过的各种概念,多少人曾为之疯狂。但是浪潮退去,裸泳者将会即刻出现。我们不应该跟随风潮进行概念炒作,相反的,我们应该反思,这些技术都解决了什么问题?

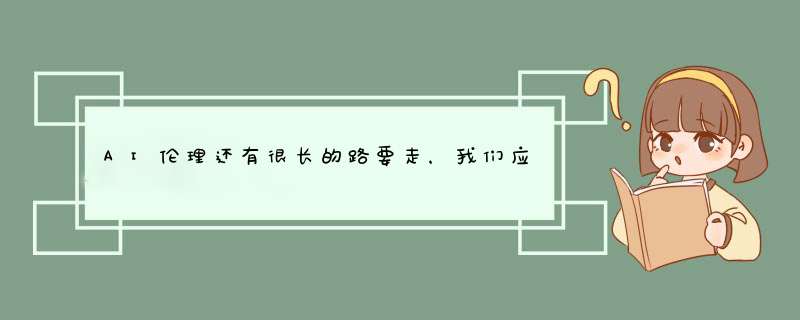

对数据科学行业来说,也是如此。让我们回顾一下单单“数据科学”一词在谷歌搜索中的趋势:

图 2: 自2013年12月以来对“数据科学”术语的搜索(来源:谷歌趋势)

可以看到,数据科学的趋势一直在稳步上升。接下来,让我们回顾2018曾发生的事情,再来看看2019年的热门话题。

2018 回顾

去年的这个时候,我也发表一篇关于2018年数据科学趋势展望的文章。在那篇文章中,我主要提到的关键词有:工程自动化,模型可解释性和公平性,数据科学应用商业化,以及特征工程工具的构建和改进。

自动化:一般来说,数据科学家的工作就是使他们的工作自动化,这句话可能有点绕口,但你认真思考以下,数据科学出现的意义就是解决大规模数据情况的分析和挖掘。而我们使用的各种模型,都是致力于提供某种较为通用的方案让机器能够自动从数据中学习知识。并且在过去的一年里,很多大公司开源了自己的模型算法,以及整个机器学习流水线的自动化,甚至连机器学习算法的建模都能自动化,参见 Google/Amazon/阿里/腾讯 等一大批公司提出的 AutoML。

商业化:正是有了这么多可用的开源工具,数据科学领域内的商业化竞争也越来越残酷。不过幸运的是,数据科学是一种横向学科,你可以只对模型进行一些微调,就可以在农业应用和医疗场景中使用相同的算法。因此,你也会发现,在2018年有很多宣称自己是 AI 公司的,如果在某个垂直方向上失败了,他们会迅速适应另一个领域。

同样也是由于这么多的开源工具,有一些公司直接对开源工具进行某种适配和修改,然后卖给其它公司。这也是2018里常常出现的一个现象。

可解释性和公平性:2018年这个领域也取得了巨大进展。现在有很多开源工具帮助解释机器学习模型学习到的知识,例如 Python 中会用到的 SHAP。 此外,还有很多书籍也在探讨这个问题,其中比较著名就有:Christoph Molnar 发表的《可解释的机器学习模型》一书(获取本书资源,请在本公众号发消息:可解释,即可获取全书)。除此之外,Google 提供的 “What-If” 工具系列,也可以帮助初学者降低学习门槛,了解机器学习复杂模型的运行原理。感谢 Google。

特征工程:虽然深度学习全面席卷整个行业,但是特征工程仍然是数据科学行业提升模型性能的主要秘诀之一。经常参加比赛的同学就会知道,在各类比赛的获胜方案中,没有哪个是单单靠模型取胜的,这些参赛者都花了很多时间在特征工程上,即便是深度模型也是如此。 因此,特征工程仍旧是一个大话题,但是在2018年,也有越来越多的通用特征处理工具和算法提了出来。

最后,根据 Stack Overflow 的统计,Python 已经成为连续两年增长最快的编程语言和最受欢迎的语言。按照这个速度,Python 应该会在不久之后成为最常用的编程语言。

2019 展望

2018年的飞速发展让我们能更广泛更轻松的应用数据科学,在2019年,数据科学家们关注的焦点是:

1. 如何最大限度地减少数据科学家花在数据清理和特征工程上的时间?

2. 如何解决机器学习模型的偏见问题?

3. 机器学习模型真的都可信吗?

抛开这些难以回答的问题,数据科学还有很多现实的问题需要解决。

强化学习在2018年可谓是如坐过山车一般,从火爆到寒冬。但是今年强化学习的春天可能要到来了,比如应用强化学习玩 Dota2 就是一个很好的例子。但是由于强化学习对于设备计算能力的要求较高,想要普及强化学习仍旧有很长的路要走。但是,无论如何,强化学习是数据科学领域目前学习方式最拟人化的模型,如果强化学习一旦广泛应用,将会是革命性的进展。

如果你对强化学习感兴趣,可以关注由 OpenAI 开发并开源的 Gym,里面有很多游戏示例可以练手。

隐私问题:2018年 facebook 由于隐私被起诉,国内也有很多公司相继爆出隐私问题。国际上,欧盟于2018年5月25日起,将要求数据科学履行他们制定的通用数据保护法规(GDPR),这些对全球的数据科学公司来说,都会有极大的影响。

目前,GDPR 主要关注以下两个方面:

- 数据隐私:任何公司如果未经用户授权,擅自使用或者超过用户的授权范围使用用户数据,会收到欧盟的巨额罚款。这带来的问题是:以后想要获取用户数据,是否会越来越困难,或者,如果我们使用匿名数据,那么这些匿名数据是否真的可信?

- 向用户解释:对于任何完全自动化的算法形成的决策,平台必须要能够向用户解释任何发生在用户身上的事情。在完全自动化的决策必须是可解释的。欧盟没有对“可解释”下更多明确的定义,但是无论如何,迄今为止有很多机器学习模型仍旧还是不容易被解释的,尤其是某些先进的高级模型。那么是否意味着:一旦我们使用前沿的高级模型,是否就代表着有巨大的罚款等着我们?

值得信赖的人工智能至少要满足这两个条件:

(1)它应该尊重人的基本权利,社会的法规、原则和价值观,并且是道德的;

(2)在技术上它应该强大可靠,避免对用户造成意外伤害

随着人工智能对社会的影响越来越大,我们有权要求这些 AI 减少偏见。幸运的是,在国外我们已经看到了很多公司和机构在努力解决这个问题,比如欧盟提出了AI道德草案,谷歌重申了AI应用的原则。AI 伦理学还有很长的路要走,希望在国内我们也能有更多关于数据隐私和道德的讨论。

图 3:欧盟 AI 道德草案

基于云的解决方案:随着人工智能算法变得越来越复杂,数据量越来越大,对计算机的要求越来越高。现在已经很少有大公司用个人电脑来进行数据科学的研究。国内如腾讯和阿里都相继提出云上的机器学习解决方案,在未来,这一定是数据科学开发、运行和部署的基本趋势。

行业细分:现在如果你搜索一个传统行业的工程师,你看到的职位名称将会非常细化,比如机械工程师吗、航天工程师、软件工程师等等。

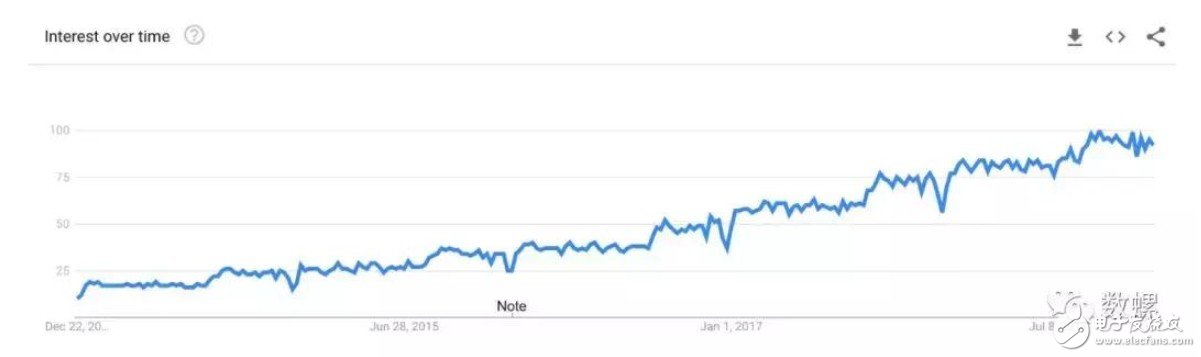

数据科学也是如此。2018年很多公司会将数据科学职位定义为“数据科学家”,但是在未来,随着行业细分专业细分,数据科学家必定也会细分下去。国外 Netflix 公司已经开了一个好头,下图中展示了 Netflix 的九个数据科学家角色:

图 4: Netflix 的数据科学家职位

这给我们的启示是:深耕一个领域。在数据科学刚开始的时候,肯定不存在许多专业化的细分领域。但随着数据科学的发展,不同领域的细分越来越明显,今年能够明显看到的就是 NLP 内部也对 NLG / NER 等工程师进行了细分。所以如果你还没有确定自己的方向的话,是时候好好思考一下了。

2019年仍将是数据科学高速发展的一年,它可能不如2018疯狂,但让我们更理性的对待数据科学本身就是一个好事。请记住,时间是你最大的资产。你浪费的每一秒都是你错失的机会。行动起来,为数据科学更理性的明天做好准备。

欢迎分享,转载请注明来源:内存溢出

微信扫一扫

微信扫一扫

支付宝扫一扫

支付宝扫一扫

评论列表(0条)