Ampere Altra 系列云原生处理器在处理流行的云原生工作负载时具有杰出的领导地位,不久前我们曾发表相关文章,重点讲述了 Ampere 的领先优势如何在原始性能上实现突破性的提升,向大家展示了其可扩展性以及显著的能效优势;在同样的峰值工作负载下,Ampere Altra Max 云原生处理器的功耗仅为传统 x86 处理器的一半。这种极具颠覆性的优势使 Ampere Altra 系列成为现代云基础设施中最具可持续性的处理器。

今年9月1日,微软发布了基于 Ampere Altra 云原生处理器的 Azure 虚拟机(VM)。本文将通过微软 Azure 虚拟机上运行的一些类似的云原生工作负载,展示 Ampere Altra 云原生处理器的领导地位。尽管我们之前的数据已经展示了 Ampere Altra Max 裸金属服务器的高性能与高能效,但全球大多数客户将首先通过基础设施即服务(IaaS,如微软 Azure 提供的服务)访问 Ampere CompuTIng 开创性的云原生处理器。终端用户只需租用配备了 Ampere Altra 云原生处理器的虚拟机实例,就可以体验到 Ampere Altra 所带来的优势。现在,让我们来具体了解一下优势究竟有哪些。

原始性能与性价比

本文将从原始性能和性价比两方面进行比较。其中,裸机比较展示的是原始性能和每瓦性能,突出了采用 Ampere 云原生处理器在助力可持续性方面的领先优势。在性价比方面,当客户从我们的云合作伙伴(如微软)租用 Ampere 虚拟机时,不仅能节约成本,能效优势也依旧凸显。更低的电力成本不但能助力构建可持续性更高的算力基础设施(例如减少碳足迹),还可以降低基础设施横向扩展时产生的平台相关拥有成本与运行成本。

访问云端服务器常常要通过虚拟机。虚拟机有各种规格与形态,可以适应云端大量的应用程序和用例。此外,云虚拟机还有不同的标准配置可供比较;这不同于我们在实验室中常进行的裸机比较。

在谈及数据之前,需要首先强调一下在比较云虚拟机性能时可能看到,但容易忽略的差异:

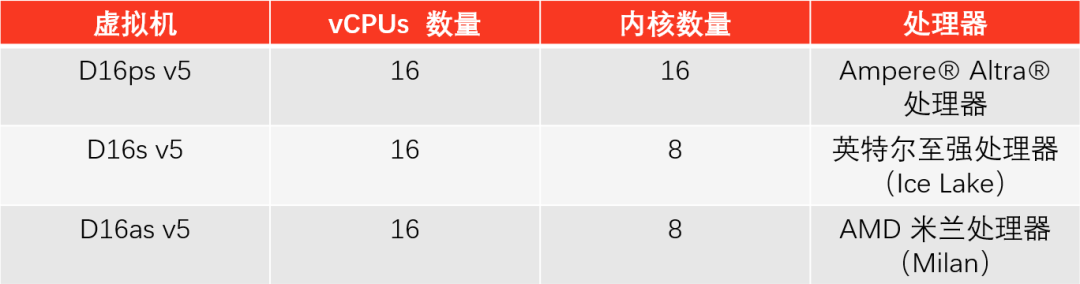

测试云端虚拟机镜像时,我们使用了 Azure 提供的标准规格。即 16 个 vCPU 的实例,这种虚拟机规格在云端最受欢迎。

在云端部署虚拟机时,需要注意不同架构之间 vCPU 的差异。传统 x86 虚拟机的每个内核有 2 个 vCPU,而 Ampere Altra 虚拟机使用单线程内核,即每个内核拥有 1 个 vCPU。这意味着,部署基于 Ampere Altra 的虚拟机,您将在虚拟机规格类似的条件下拥有 2 倍的内核数量。

根据现有的可适用 Azure 服务列表,我们使用了存储和网络中的等效服务。

为实现同等产品的比较,本文收集和显示的所有数据都通过运行搭载 16 个 vCPU 的虚拟机获得。

我们测试的虚拟机如下表所示。

除了为每种工作负载收集的原始性能数据以外,我们还用已发布的按需定价信息(即用即付)计算了在 Azure 虚拟机上运行特定工作负载的总价格。定价信息来源于 Azure 官网,信息可能会有变动。

性价比值 = (在同等规格的虚拟机上提供同等服务时,所运行工作负载测得的综合性能优势) * (每种可比较虚拟机的成本优势)

现在让我们聚焦收集到的数据。以下所列的工作负载均为实际服务安装中流行的云原生工作负载,因此它们代表了多数终端客户在公有云基础设施中部署的工作负载。

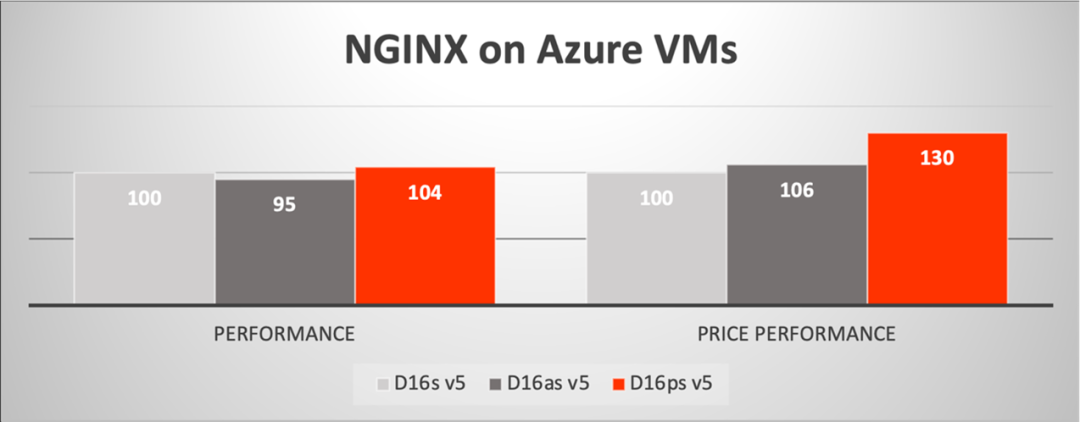

Web 服务

首先来看 NGINX,这是一种非常流行的 HTTP Web 服务器。我们已经展示过 NGINX 在 Socket 层面如何在原始性能和能效方面都远超传统 x86 生态。而在具有 16 个 vCPU 的虚拟机方面,可以看出 Ampere Altra 的性能优势及其价格优势(与上述提及的能效相关);与英特尔的 Dsv5 和 AMD 的 Dasv5 相比,Ampere 的虚拟机性价比高达 30%(此处的性能和性价比的比较是相对于 Intel 的 Dsv5 虚拟机而言)。

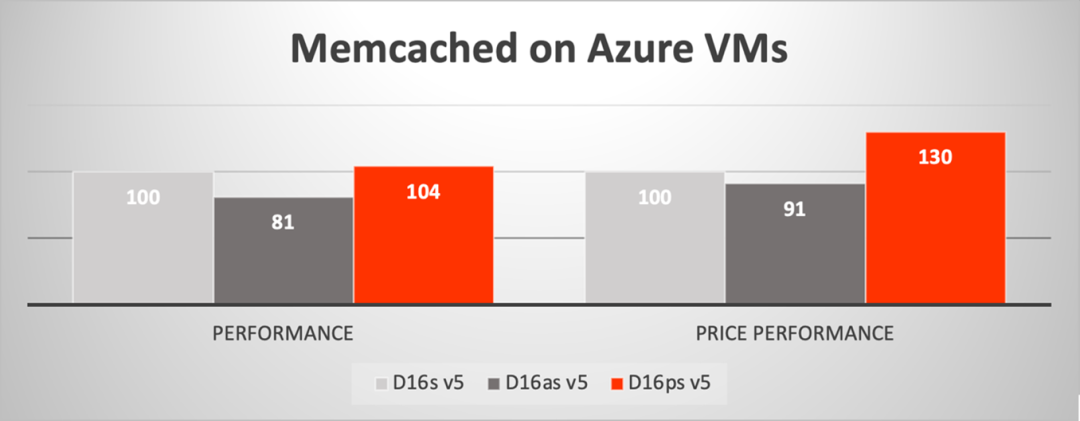

内存缓存

Memcached 是一种广泛应用的存内键值储存,在它身上,我们也看到了类似的结果。对内存缓存而言,在我们测试范围内的 8 至 16 个 vCPU 的虚拟机很常见,而我们测得的整体性能值对包含缓存层的微服务等工作负载非常有吸引力。通过测试,我们得到的 Ampere 性价比相较于 Intel 的 Dsv5 虚拟机高 30%,比 AMD 的 Dasv5 虚拟机高 43%。

视频服务

视频编码被认为是许多云服务的大宗应用程序,视频编码因此也成为一种高容量和高度优化的工作负载。就算法优化和编解码器效率而言,Arm 生态系统已经占据有利地位。

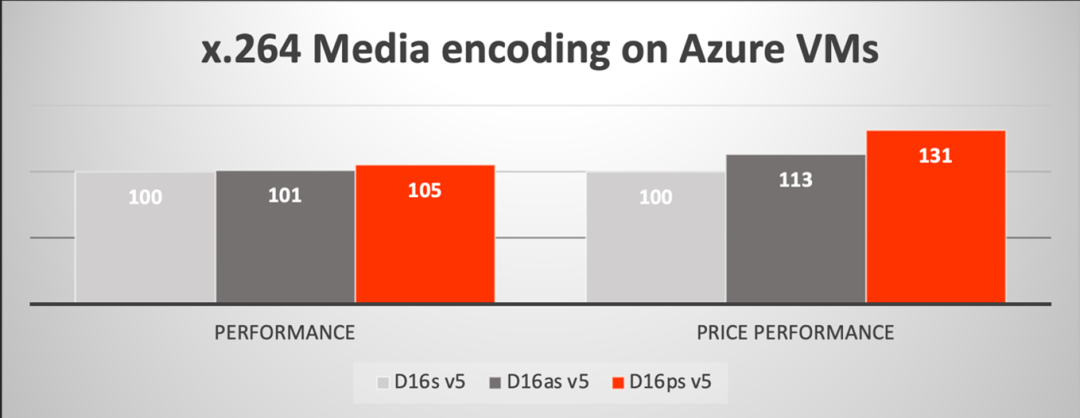

基于此,在视频上传(Video Upload)和视频点播(VoD)这两个场景中,我们利用 x.264 编码库在 vBench 上运行媒体编码。在 Ampere 的虚拟机中,这两种场景的测试非常类似,因此我们仅展示上传场景的数据。该场景采用了不会降低输入视频质量的单程转码,这也表明了视频服务的初始上传编码对速度和质量有所要求。测试结果显示,16 个 vCPU 的 Ampere 虚拟机与传统 x86 虚拟机的性能大致相当;但根据公布的定价来看,性价比提高了 30%。

AI 推理

最后我们来看 AI 推理基准测试。

随着人工智能成为许多网络和独立服务不可或缺的组成部分,机器学习在云端消耗的周期越来越多。Ampere 为此编译了一个易于使用的堆栈,以加速计算机视觉、自然语言处理和推荐引擎用例中的典型 AI 工作负载。Ampere AI 再将此加速层与常见的开源 AI 框架(例如 TensorFlow、PyTorch 和 ONNX)相结合。其美妙之处就在于,用户可以自由选择与其框架兼容的模型,并运行于 Ampere 云原生处理器的优化流程之中。用户无需对模型进行任何更改即可完成任务,同时,借助 Ampere 处理器的独特功能,例如 fp16 这种数据格式,可以得到普通 fp32 格式约 2 倍的性能,但精度几乎无损失。上述常见 AI 框架的免费镜像在 Ampere 解决方案网站上都可以找到,Azure 市场上也会很快推出。

利用一组通用的基准测试,我们使用 MLPerf Resnet50 v1.5 比较了 AI 推理在单流和离线场景中的表现。这些场景代表了数据中心图像分类中最常见的用例,分别反映了延迟敏感度(一次一帧或一张图像)和批量吞吐量(尽可能多地并行返回) *** 作。在 D16ps v5 虚拟机上进行这些基准测试,基于带 Ampere AI 容器镜像的 TensorFlow 2.7 框架运行,同时采用 FP16 数据格式;再用传统 x86 进行这些基准测试,基于带 DNNL 的 TensorFlow 2.7 框架,并采用 fp32 数据格式。将二者进行比较,结果表明,采用所述格式进行的 Ampere 测试,其模型精度非常高。与传统 x86 虚拟机相比,Ampere AI 技术的性能提升超过 2 倍,而性价比更是超越 2 到 3 倍!

结语

无论是部署新的 Web 服务,还是优化人工智能、视频编码、数据管理与分析中等现有服务,云端开发人员都可以选择成本更低但性能更高的方案,取代目前广泛使用的传统基础设施。过去,低价代表着低性能。但现在,这种情况已不复存在!微软 Azure 的用户不再需要做出取舍,鱼与熊掌可以兼得。更令人欣慰的是,这样做不但能极大地节省成本,而且不以牺牲性能为代价,还可以节能减排。

审核编辑:刘清

欢迎分享,转载请注明来源:内存溢出

微信扫一扫

微信扫一扫

支付宝扫一扫

支付宝扫一扫

评论列表(0条)