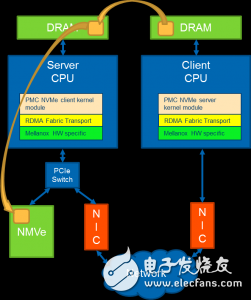

NVMe over RDMA (NoR) 展示出将NVMe协议延展到RDMA之上的潜在可能。该项演示中共采用了两台电脑,一台作为客户端,另一台则作为服务器——其中配备Mellanox ConnectX-3 Pro NIC,且通过RoCEv2相连。演示中所采用的NVMe设备即为性能极高而延迟极低的PMC Flashtec NVRAM 加速卡。下图为该演示的框图。

此演示显示出,利用RDMA来传送NVMe命令及数据结果带来了微乎其微的额外延迟,且不影响吞吐量。

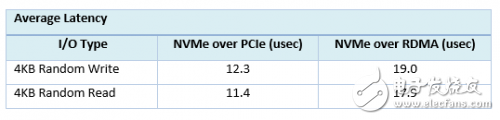

对比本地NVMe设备与远端NVMe设备的平均延迟,如下表所示,NoR方案中延迟增加低于10微妙。

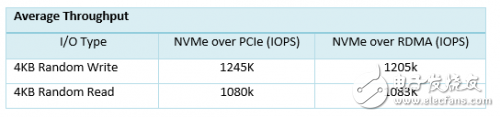

而另外这组数据则对比了本地NVMe设备与远端NVMe设备吞吐量的测试结果。从下表中可以看出,NoR方案中吞吐量并无减少。

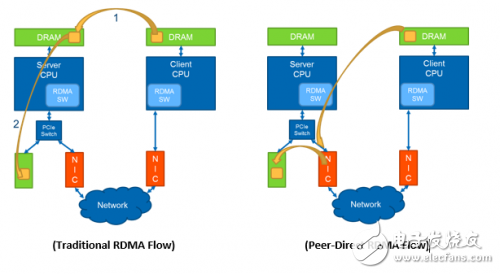

此项演示中,通过在标准 RDMA之上增加服务器CPU和DRAM的分流,采用对端发起的方式来将远端客户端与一台服务器的NVRAM/NVMe设备直连。我们将Mellanox提供的RoCEv2-capable ConnectX-3 Pro RDMA NIC与PMC的Flashtec NVRAM加速卡组合在一起,实现NIC和NVRAM之间的对端发起 *** 作。对端发起 *** 作可以实现远端客户对NVRAM加速卡的直接访问,相比传统的RDMA流程,可降低延迟,且有效地释放CPU和DRAM资源。

同样,该演示采用的两台电脑,一台作为客户端,另一台则作为服务器。利用服务器中的PCIe交换设备可以将对端发起 *** 作的性能大大提升。

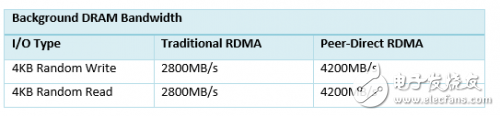

对比采用传统RDMA和对端发起的RDMA时服务器上可用的后台DRAM带宽,用perftest得出的数据如下:

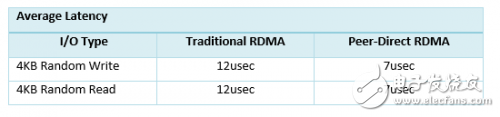

下表则对采用传统RDMA和对端发起的RDMA时的平均延迟作出了比较,结果得自于RDMA mode of fio:

RDMA以及NVMe两项技术均处于蓬勃上升的阶段,RDMA能提供远距离、大规模的低延迟及高效率的数据移动,而NVMe则能提供对SSD的低延迟访问。将两项技术相结合能实现非凡的性能。

欢迎分享,转载请注明来源:内存溢出

微信扫一扫

微信扫一扫

支付宝扫一扫

支付宝扫一扫

评论列表(0条)