(文章来源:OFweek)

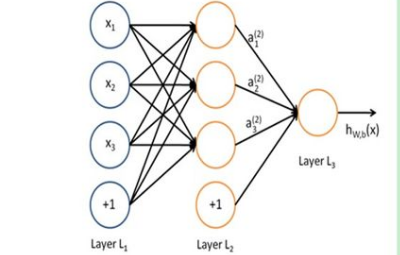

深度学习DL是机器学习中一种基于对数据进行表征学习的方法。深度学习DL有监督和非监督之分,都已经得到广泛的研究和应用。强化学习RL是通过对未知环境一边探索一边建立环境模型以及学习得到一个最优策略。强化学习是机器学习中一种快速、高效且不可替代的学习算法。

深度强化学习DRL自提出以来, 已在理论和应用方面均取得了显著的成果。尤其是谷歌DeepMind团队基于深度强化学习DRL研发的AlphaGo,将深度强化学习DRL成推上新的热点和高度,成为人工智能历史上一个新的里程碑。因此,深度强化学习DRL非常值得研究。

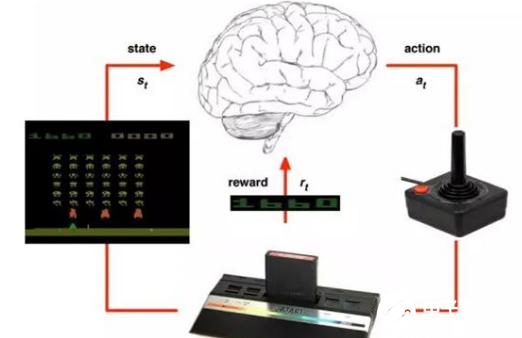

深度强化学习概念:深度强化学习DRL将深度学习DL的感知能力和强化学习RL的决策能力相结合, 可以直接根据输入的信息进行控制,是一种更接近人类思维方式的人工智能方法。在与世界的正常互动过程中,强化学习会通过试错法利用奖励来学习。它跟自然学习过程非常相似,而与深度学习不同。在强化学习中,可以用较少的训练信息,这样做的优势是信息更充足,而且不受监督者技能限制。

深度强化学习DRL是深度学习和强化学习的结合。这两种学习方式在很大程度上是正交问题,二者结合得很好。强化学习定义了优化的目标,深度学习给出了运行机制——表征问题的方式以及解决问题的方式。将强化学习和深度学习结合在一起,寻求一个能够解决任何人类级别任务的代理,得到了能够解决很多复杂问题的一种能力——通用智能。深度强化学习DRL将有助于革新AI领域,它是朝向构建对视觉世界拥有更高级理解的自主系统迈出的一步。从某种意义上讲,深度强化学习DRL是人工智能的未来。

深度强化学习本质:深度强化学习DRL的Autonomous Agent使用强化学习的试错算法和累计奖励函数来加速神经网络设计。这些设计为很多依靠监督/无监督学习的人工智能应用提供支持。它涉及对强化学习驱动Autonomous Agent的使用,以快速探索与无数体系结构、节点类型、连接、超参数设置相关的性能权衡,以及对深度学习、机器学习和其他人工智能模型设计人员可用的其它选择。

深度强化学习原理:深度Q网络通过使用深度学习DL和强化学习RL两种技术,来解决在强化学习RL中使用函数逼近的基本不稳定性问题:经验重放和目标网络。经验重放使得强化学习RL智能体能够从先前观察到的数据离线进行抽样和训练。这不仅大大减少了环境所需的交互量,而且可以对一批经验进行抽样,减少学习更新的差异。此外,通过从大存储器均匀采样,可能对强化学习RL算法产生不利影响的时间相关性被打破了。最后,从实际的角度看,可以通过现代硬件并行地高效地处理批量的数据,从而提高吞吐量。

(责任编辑:fqj)

欢迎分享,转载请注明来源:内存溢出

微信扫一扫

微信扫一扫

支付宝扫一扫

支付宝扫一扫

评论列表(0条)