据报导,正值全球芯片短缺之际,台积电提高了芯片价格并推迟了3nm制程的生产进程。无论这类新闻是否准确或预示着一种长期趋势,它们都在提醒我们,摩尔定律的衰退将带来越来越严重的影响,并迫使我们重新思考人工智能硬件——它会受到这种衰退的影响,还是会帮助扭转这种趋势?

如果我们希望恢复摩尔定律(Moore’s Law)的良性循环,这其中,软件和硬件曾经相互加持,使一部现代智能手机比过去10年占据整个仓库的超级计算机功能更强大。人们普遍接受后摩尔时代的良性循环是基于更大的数据迸发更大的模型并需要更强大的机器。但事实上,这样的循环是不可持续的。

除非我们重新定义并行性,我们不能再指望缩小晶体管来制造越来越宽的并行处理器。我们也不能依赖于它,除非特定领域架构(DSA)有助于促进及适应软件的发展。

与其搞清楚哪类硬件是用于 AI 这个不断发展的移动目标,我们不如从AI以可微分编程为核心的角度来看待AI 硬件。这样说,人工智能软件程序是一个计算图,由一起训练实现端到端目标的计算节点组成。只要一个深度线程DSA硬件是可微的,它就可以作为一个计算节点。软件程序员可以自由地将可微硬件插入计算图中,以实现高性能和以创意解决问题,就像预构建的可定制软件组件一样。AI 硬件不应再有"血统纯正度"审查,毕竟它现在可以包括各样可微硬件。

但愿这样,软件和硬件将再次通过良性循环并行发展,就像摩尔定律盛行时那样。

人工智能硬件架构师的苦恼

在人工智能市场的众多GPU竞争者中,特斯拉推出了Dojo超级计算机。Dojo似乎是网络、集成和可延展性方面的杰作。而另一方面,Dojo 的组件 D1 芯片则称不上是架构上的突破。 我们可以将GPU竞争者分为两个阵营,Many-Core 和Many-MAC。D1是Many-Core阵营的一个例子,它是将多个CPU核心连接起来的“网格”。另一方面,特斯拉FSD或谷歌TPU是Many-MAC阵营的缩影,其特点是少量大型矩阵乘法(MM)加速,每个都在一个“网格”中封装许多乘累积(MAC)单元。正如我们所看到的,关于AI架构的争论可以说是处于网格和GPU之间。

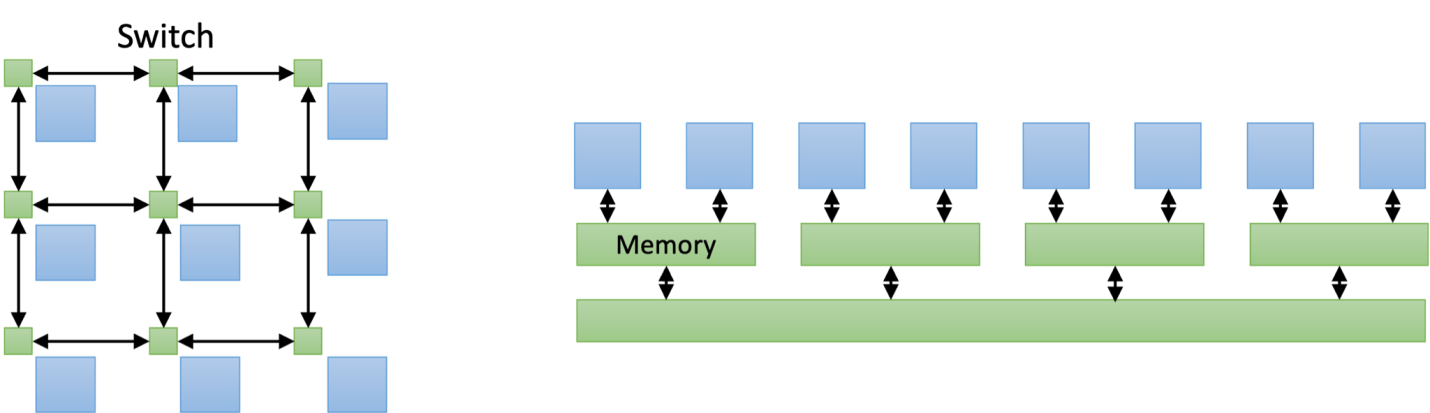

在制造芯片带来的飞速增长的冲力下,AI硬件架构师面对着巨大压力,总是胆战心惊的看待媒体对基准测试和学术大会的报导。人工智能硬件常常跑不动基准测试和最新出炉的NN模型,而讽刺的是,这些模型在所谓“老掉牙”的GPU上,却运行良好。如下图所示,Many-Core和GPU本质上只是数据交换方式有所不同。前者通过一个互联的网格传递数据,而后者通过一个存储器层次结构共享数据。这种差异与人工智能没有什么关系。Many-Core芯片(如D1芯片)是否最终会超过GPU,还有待观察。稍后我将介绍Many-MAC 。

欢迎分享,转载请注明来源:内存溢出

微信扫一扫

微信扫一扫

支付宝扫一扫

支付宝扫一扫

评论列表(0条)