作者:Sharon Goldman

机器之心编译

深度学习未来会更好还是走下坡路?AI 圈先驱们展开了设想。

自 2012 年,以 AlexNet 为代表的深度学习技术突破开始,至今已有 10 年。 10 年后,如今已经成为图灵奖得主的 Geoffrey Hinton、Yann LeCun,ImageNet 挑战赛的主要发起人与推动者李飞飞如何看待过去十年的 AI 技术突破?又对接下来十年的技术发展有什么判断? 近日,海外媒体 VentureBeat 的一篇专访文章,让 AI 社区开始讨论起这些问题。

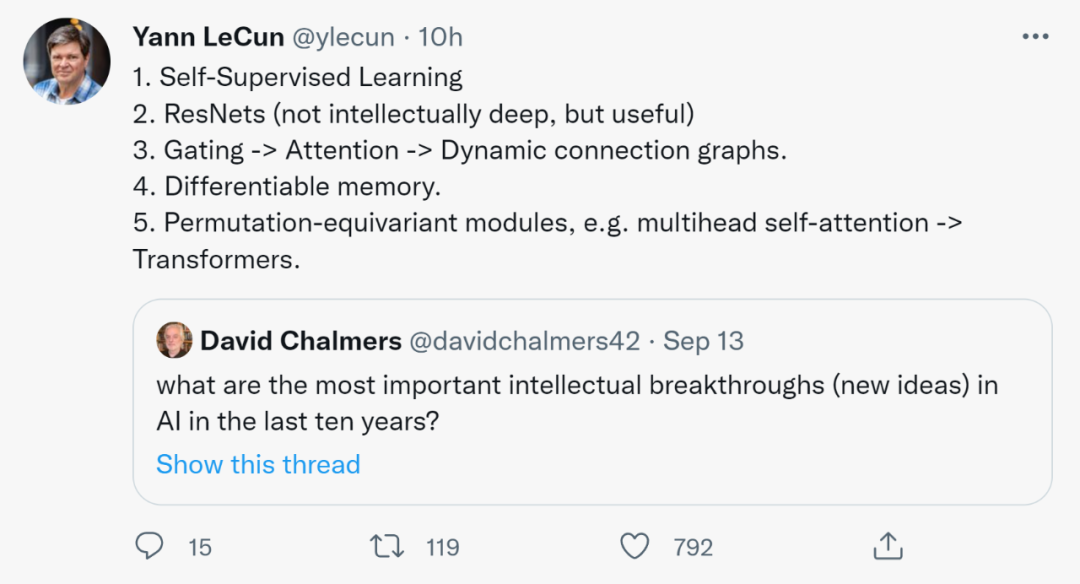

在LeCun看来,过去十年最重要的成果包括自监督学习、ResNets、门-注意力-动态连接图、可微存储和置换等变模块,例如多头自注意力-Transformer。

Hinton 认为,AI 领域的快速发展势头将继续加速。此前,他与其他一些 AI 领域知名人士对「深度学习已经碰壁」这一观点进行了反驳。Hinton 表示,「我们看到机器人领域出现了巨大进步,灵活、敏捷且更顺从的机器人比人类更高效、温和地做事情。」

LeCun 和李飞飞赞同 Hinton 的观点,即 2012 年基于 ImageNet 数据集的一系列开创性研究开启了计算机视觉尤其是深度学习领域的重大进步,将深度学习推向了主流,并引发了一股难以阻挡的发展势头。李飞飞对此表示,自 2012 年以来的深度学习变革是她做梦也想不到的。

不过,成功往往会招致批评。最近,很多观点纷纷指出了深度学习的局限性,认为它的成功仅限于很小的范围。这些观点认为深度学习无法实现其宣称的根本性突破,即最终帮助人类实现期望的通用人工智能,其中 AI 的推理能力真正地类似于人类。

知名 AI 学者、Robust.AI 创始人 Gary Marcus 在今年三月发表了一篇《深度学习撞墙了》的文章,他认为纯粹的端到端深度学习差不多走到尽头了,整个 AI 领域必须要寻找新出路。之后,Hinton 和 LeCun 都对他的观点发起了驳斥,由此更引发了圈内热议。

虽然批评的声音不断,但他们不能否认计算机视觉和语言等关键应用已经取得了巨大进展。成千上万的企业也见识到了深度学习的强大力量,并在推荐引擎、翻译软件、聊天机器人以及更多其他领域取得了显著的成果。 2022 年了,当我们回顾过往蓬勃发展的 AI 十年,我们能从深度学习的进展中学到什么呢?这一改变世界的变革性技术未来会更好还是走下坡路呢?Hinton、LeCun、李飞飞等人对此发表了自己的看法。

2012 年,深度学习变革的开始

一直以来,Hinton 坚信深度学习革命的到来。1986 年,Hinton 等人的论文《Learning representaTIons by back-propagaTIng errors》提出了训练多层神经网络的反向传播算法,他便坚信这就是人工智能的未来。之后,1989 年率先使用反向传播和卷积神经网络的 LeCun 对此表示赞同。 Hinton 和 LeCun 以及其他人认为多层神经网络等深度学习架构可以应用于计算机视觉、语音识别、自然语言处理和机器翻译等领域,并生成媲美甚至超越人类专家的结果。与此同时,李飞飞也提出了自己深信不疑的假设,即只要算法正确,ImageNet 数据集将成为推进计算机视觉和深度学习研究的关键。 到了 2012 年,Alex Krizhevsky、Ilya Sutskever 和 Hinton 的论文《ImageNet ClassificaTIon with Deep ConvoluTIonal Neural Networks》问世,使用 ImageNet 数据集创建了今天大家非常熟悉的 AlexNet 神经网络架构,并获得了当年的 ImageNet 竞赛冠军。这个在当时具有开创性意义的架构在分类不同的图像方面比以往方法准确得多。

论文地址:https://proceedings.neurips.cc/paper/2012/file/c399862d3b9d6b76c8436e924a68c45b-Paper.pdf

可以这么说,这项研究在 ImageNet 数据集和更强大 GPU 硬件的加持下,直接促成了下个十年的主要 AI 成功案例,比如 Google Photos、Google Translate、Amazon Alexa、OpenAI DALL-E 和 DeepMind AlphaFold 等。 在 AlexNet 推出的 2012 年,也有其他人和机构开始转向深度学习研究领域。Google X 实验室构建了一个由 16000 个计算机处理器组成的神经网络,它具有 10 亿个连接,并逐渐能够识别类猫(cat-like)特征以及高度准确地识别 YouTube 上的猫视频。 与此同时,Jeffrey Dean 和 Andrew Ng 也在大规模图像识别领域进行突破性工作。Dan Ciregan 等人中稿 CVPR 2012 的论文显著提高了卷积神经网络在多个图像数据集上的 SOTA 性能。

编辑:黄飞

欢迎分享,转载请注明来源:内存溢出

微信扫一扫

微信扫一扫

支付宝扫一扫

支付宝扫一扫

评论列表(0条)